La chose curieuse qu'un certain nombre de chercheurs Google Home, Siri et Alexa ont été piratés par projection de lumière laser en eux, ce n'est pas la nouvelle elle-même, qui a sa propre chose, mais elle n'est toujours pas connue avec certitude parce que ces assistants réagissent à la lumière comme si elle était sonore.

On en parle trois assistants sont vulnérables aux attaques ils souffrent de lasers qui «injectent» des commandes lumineuses inaudibles et parfois invisibles dans les dispositifs pour provoquer le déverrouillage des portes, visiter des sites Web ou même localiser des véhicules.

Assistant, Siri et Alexa piratés

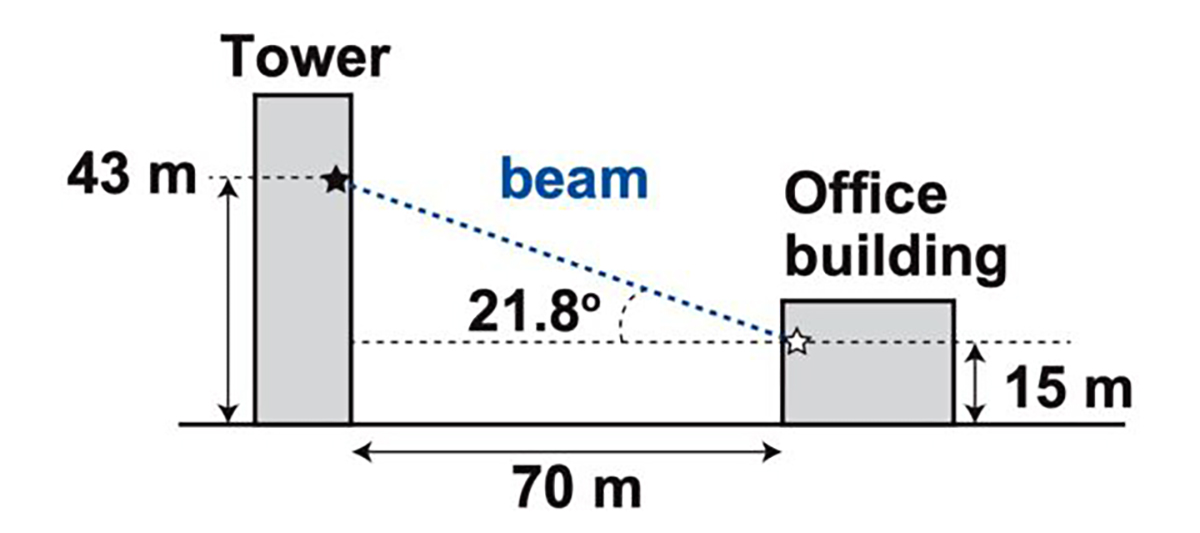

Et c'est à une distance de 110 mètres à partir de laquelle vous pouvez projeter une lumière laser basse fréquence pour activer ces systèmes vocaux dans lequel des commandes sont "injectées" qui effectuent ensuite une grande variété d'actions. Ces chercheurs ont même pu envoyer ces types de commandes lumineuses d'un bâtiment à un autre et passer à travers la vitre pour atteindre l'appareil avec Google Assistant ou Siri.

Autant que l'on sache, l'attaque profite d'une vulnérabilité existante dans les microphones et que utiliser ce qu'on appelle MEMS (systèmes micro-électromécaniques). Les composants MEMS microscopiques répondent involontairement à la lumière sous forme de son.

Et alors que les chercheurs ont testé ce type d'attaque sur Google Assistant, Siri, Alexa, comme même sur le portail Facebook et une petite série de tablettes et de téléphones, ils commencent à croire que tous les appareils qui utilisent des microphones MEMS sont susceptibles d'être attaqués par ces soi-disant «commandes lumineuses».

Une nouvelle forme d'attaque

Ces types d'attaques présentent un certain nombre de limitations. Le premier est que l'attaquant doit avoir une ligne de vue directe sur l'appareil celui que vous voulez attaquer. La seconde est que la lumière doit être focalisée très précisément sur une partie très spécifique du microphone. Il convient également de noter qu'à moins que l'attaquant n'utilise un laser infrarouge, la lumière serait facilement visible par toute personne proche de l'appareil.

Les résultats de cette série de chercheurs sont assez importants pour plusieurs raisons. Non seulement en étant capable d'attaquer cette série d'appareils à commande vocale qui gèrent certains appareils importants dans une maison, mais aussi montre comment les attaques peuvent être effectuées dans des environnements presque réels.

Ce qui attire beaucoup l'attention, c'est que la raison du "physique" n'est pas entièrement comprise des commandes légères qui font partie de l '«exploit» ou de la vulnérabilité. En fait, savoir pourquoi cela se produit signifierait en fait un meilleur contrôle et des dégâts sur l'attaque.

Il est également frappant que cette série d'appareils à commande vocale ne portent pas une sorte d'exigence de mot de passe ou de PIN. Autrement dit, si vous êtes en mesure de les "pirater" avec ce type d'émission de lumière, vous pouvez contrôler une maison entière dans laquelle un assistant Google ou Siri contrôle les lumières, le thermostat, les serrures de porte et plus encore. Presque comme un film.

Attaque à faible coût

Et nous pourrions imaginer qu'avoir un projecteur laser peut vous coûter cher. Ou qu'au moins le coût était élevé pour pouvoir perpétrer une attaque de ce style. Pour rien. L'un des paramètres des attaques implique une dépense de 390 $ avec l'acquisition d'un pointeur laser, d'un pilote laser et d'un amplificateur de son. Si nous avons déjà plus de gourmands, nous ajoutons un téléobjectif pour 199 $ et nous pouvons viser de plus grandes distances.

Vous vous demandez peut-être qui sont les chercheurs derrière cette découverte surprenante qui montre une nouvelle façon d'attaquer une série d'appareils que nous installons tous dans nos maisons. Eh bien, nous parlons de Takeshi Sugawara de l'Université d'électro-communications au Japonet Sara Rampazzi, Benjamin Cyr, Daniel Genkin et Kevin Fu de l'Université du Michigan. En d'autres termes, si à un moment donné vous pensiez que nous parlions de fantaisie, pas du tout, une réalité.

Une nouvelle attaque pour les appareils à commande vocale Google Assistant, Siri et Alexa avec des commandes légères et qui auront une queue dans les années à venir ; un Assistant Google qui s'intègre à WhatsApp, alors imaginez un peu ce qui peut être fait avec ces attaques.