Das Merkwürdige, was eine Reihe von Forschern Google Home, Siri und Alexa wurden durch Projektion von Laserlicht gehackt in ihnen ist es nicht die Nachricht selbst, die ihr eigenes Ding hat, aber es ist immer noch nicht sicher bekannt, weil diese Assistenten auf Licht reagieren, als ob es Ton wäre.

Wir reden darüber Drei Assistenten sind anfällig für Angriffe Sie leiden unter Lasern, die unhörbare und manchmal unsichtbare Lichtbefehle in Geräte "injizieren", um Türen zu entriegeln, Websites zu besuchen oder sogar Fahrzeuge zu lokalisieren.

Assistent, Siri und Alexa gehackt

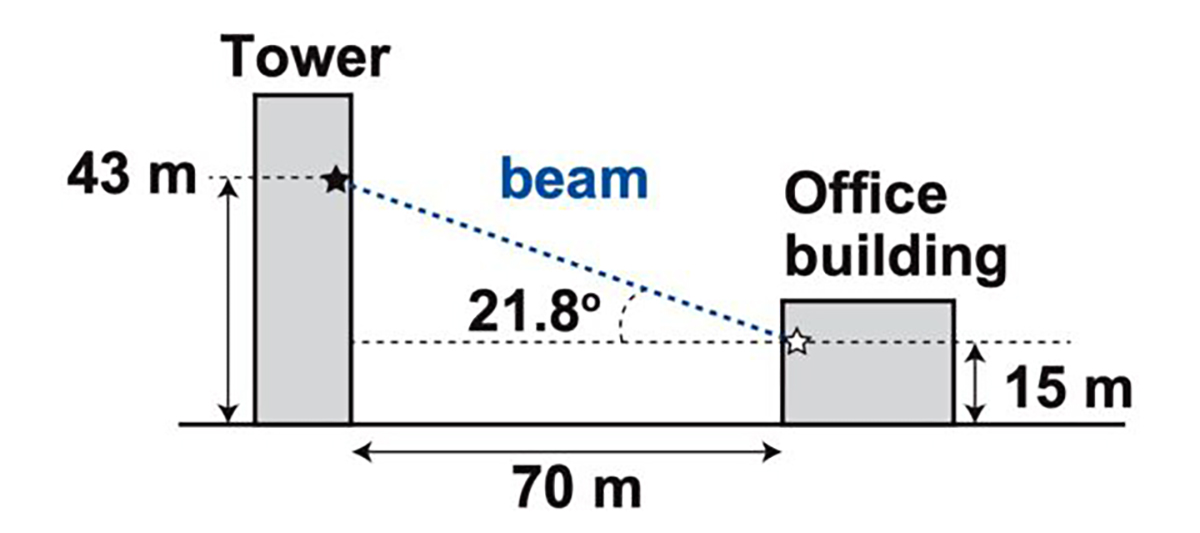

Und es ist in einer Entfernung von 110 Metern, von der Sie können Projizieren Sie niederfrequentes Laserlicht, um diese Sprachsysteme zu aktivieren in denen Befehle "injiziert" werden, die dann eine Vielzahl von Aktionen ausführen. Diese Forscher konnten sogar diese Art von Lichtbefehlen von einem Gebäude zum anderen senden und durch das Glas gehen, um das Gerät mit Google Assistant oder Siri zu erreichen.

Soweit wir das beurteilen können, nutzt der Angriff eine vorhandene Sicherheitslücke in den Mikrofonen aus Verwenden Sie das, was als MEMS bezeichnet wird (Mikroelektromechanische Systeme). Mikroskopische MEMS-Komponenten reagieren unbeabsichtigt auf Licht als Schall.

Und während Forscher diese Art von Angriff auf Google Assistant getestet haben, haben Siri, Alexa, wie z sogar auf dem Facebook-Portal und einer kleinen Reihe von Tablets und HandysSie beginnen zu glauben, dass alle Geräte, die MEMS-Mikrofone verwenden, von diesen sogenannten «Lichtbefehlen» angegriffen werden können.

Eine neue Form des Angriffs

Diese Arten von Angriffen weisen eine Reihe von Einschränkungen auf. Das erste ist das Der Angreifer muss eine direkte Sichtlinie zum Gerät haben wen du angreifen willst. Das zweite ist, dass das Licht sehr genau auf einen bestimmten Teil des Mikrofons fokussiert werden muss. Denken Sie auch daran, dass das Licht von jedem, der sich in der Nähe des Geräts befindet, leicht gesehen werden kann, wenn der Angreifer keinen Infrarotlaser verwendet.

Die Ergebnisse dieser Reihe von Forschern sind aus mehreren Gründen sehr wichtig. Nicht nur, weil diese Serie sprachgesteuerter Geräte, die einige wichtige Geräte in einem Heim verwalten, angegriffen werden kann, sondern auch zeigt, wie Angriffe ausgeführt werden können in fast realen Umgebungen.

Was viel Aufmerksamkeit auf sich zieht, ist dass der Grund für das "physische" nicht vollständig verstanden ist der Lichtbefehle, die Teil des "Exploits" oder der Sicherheitslücke werden. Zu wissen, warum es passiert, würde in der Tat eine größere Kontrolle und mehr Schaden über den Angriff bedeuten.

Auffällig ist auch, dass diese Serie sprachgesteuerter Geräte Tragen Sie keine Passwort- oder PIN-Anforderungen. Das heißt, wenn Sie sie mit dieser Art von Lichtemission "hacken" können, können Sie ein ganzes Haus steuern, in dem ein Google-Assistent oder Siri die Lichter, den Thermostat, die Türschlösser und mehr steuert. Fast wie ein Film.

Kostengünstiger Angriff

Und wir könnten uns vorstellen, dass ein Laserlichtprojektor Sie kosten kann. Oder dass zumindest die Kosten hoch waren, um einen Angriff dieses Stils ausführen zu können. Gar nicht. Eine der Einstellungen für Angriffe beinhaltet eine Ausgabe von 390 $ mit dem Erwerb eines Laserpointers, eines Lasertreibers und eines Schallverstärkers. Wenn wir bereits mehr Feinschmecker bekommen, fügen wir ein Teleobjektiv für 199 US-Dollar hinzu und können größere Entfernungen anstreben.

Sie mögen sich fragen, wer die Forscher hinter diesem überraschenden Ergebnis stecken, das eine neue Art des Angriffs auf eine Reihe von Geräten zeigt, die wir alle in unsere Häuser stecken. Nun, wir reden darüber Takeshi Sugawara von der Universität für Elektrokommunikation in Japanund Sara Rampazzi, Benjamin Cyr, Daniel Genkin und Kevin Fu von der University of Michigan. Mit anderen Worten, wenn Sie irgendwann dachten, wir sprachen über Fantasie, überhaupt nicht über Realität.

Eine neuer Angriff für sprachgesteuerte Geräte von Google Assistant, Siri und Alexa mit leichten Befehlen und das wird in den kommenden Jahren einen Schwanz haben; ein Google Assistant, der sich in WhatsApp integrieren lässt, stellen Sie sich also ein wenig vor, was mit diesen Angriffen gemacht werden kann.